Хотите узнать раньше всех об открытии и получить бесплатный доступ?

Coming soon

Бесплатные скрипты для поискового оптимизатора и интернет маркетолога

Скрипт проверки по ссылке - check-mail.txt.

При запуске на сервере сохранить с .php

Способ #1

Способ #2

var checkSitemapXml = function() {

var urls = [],

code2x = {},

code3x = {},

code4x = {},

code5x = {};

$.get("/sitemap.xml").success(function(response) {

var $xml = $(response);

var pages = $xml.find("loc");

console.log("parsed " + pages.length + " URLs");

pages.each(function(i, el) {

var url = $(el).text();

urls.push(url);

});

checkResponseCode();

});

function checkResponseCode() {

if (urls.length === 0) {

console.log("Status: \n2xx: " + _.size(code2x));

if (_.size(code3x) > 0) {

console.log("3xx: \n" + JSON.stringify(code2x, null, 4));

}

if (_.size(code4x) > 0) {

console.log("4xx: \n" + JSON.stringify(code4x, null, 4));

}

if (_.size(code5x) > 0) {

console.log("5xx: \n" + JSON.stringify(code5x, null, 4));

}

return;

}

var url = urls.shift();

$.get(url).complete(function(jqXHR) {

if (jqXHR.status < 300) code2x[url] = jqXHR.status;

else if (jqXHR.status < 400) code3x[url] = jqXHR.status;

else if (jqXHR.status < 500) code4x[url] = jqXHR.status;

else if (jqXHR.status >= 500) code5x[url] = jqXHR.status;

console.debug(urls.length);

checkResponseCode();

});

}

};

checkSitemapXml()Инструкция запрещает ботам парсить сайты на уровне сервера. Носит не рекомендательный харакетер как robots.txt, а серверный запрет на обработку запросов от ботов. Прописать в .htaccess:

Options FollowSymLinks ExecCGI

RewriteEngine On

RewriteBase /

RewriteCond %{REQUEST_FILENAME} !-f

RewriteCond %{REQUEST_FILENAME} !-d

RewriteRule ^[^4]* /404 [L,S=4000]

RewriteEngine on

RewriteCond %{HTTP_USER_AGENT} ".*AhrefsBot.*" [OR]

RewriteCond %{HTTP_USER_AGENT} ".*MJ12bot.*" [OR]

RewriteCond %{HTTP_USER_AGENT} ".*rogerBot.*" [OR]

RewriteCond %{HTTP_USER_AGENT} ".*MegaIndex\.ru/2\.0.*" [OR]

RewriteCond %{HTTP_USER_AGENT} ".*YandexBot.*" [OR]

RewriteCond %{HTTP_USER_AGENT} ".*ia_archiver.*" [OR]

RewriteCond %{HTTP_USER_AGENT} ".*bingbot.*" [OR]

RewriteCond %{HTTP_USER_AGENT} ".*Baiduspider.*" [OR]

RewriteCond %{HTTP_USER_AGENT} ".*archive\.org_bot.*" [OR]

RewriteCond %{HTTP_USER_AGENT} ".*BLEXBot.*" [OR]

RewriteCond %{HTTP_USER_AGENT} ".*LinkpadBot.*" [OR]

RewriteCond %{HTTP_USER_AGENT} ".*spbot.*" [OR]

RewriteCond %{HTTP_USER_AGENT} ".*Serpstatbot.*"

RewriteRule ".*" "-" [F]

Проверка через расширение для Google Chrome Restlet

Провести постранично сбор доменных имен с поисковой выдачи Bing можно использую следующий алгоритм действий:

Провести постранично сбор доменных имен с поисковой выдачи Yandex можно использую следующий алгоритм действий:

My seacrh optimization experience more than 10 years.

I am specialist search engine optimization. When promoting use of technology predominantly white search optimisation of a website and known as a technical SEO and loves doing technical SEO audits as well as troubleshooting issues. I am:

Search engine optimization (SEO)

Contextual advertising

Social Media Marketing

Display advertising (RTB)

Technology and development

Monetization and earnings

Web Analytics

Seminars and conferences

Startups

тут здесь такой вот ссылка этот описание вот такой этого такую такие эта сюда этой ссылке вот этот такое этих этим выбирай вот такую есть таких этом таким моя ссылка вот тут подробнее пример этому вот так линк по этой ссылке подробное описание этой ссылке такой вот вот она вот эти источник клик подробности посмотреть вот здесь вот например такой тута вот что здесь описание тут ссылочка такими такой вариант типа такого этот вот такой вот этого еще по ссылке подробнее посетить сайт автора рекомендую этими вот ссылка вот такое вот, например как-то так пишут смотри ссылку такому типа этого вариантов взял вот такой вот вот. подобное подробное описание тут полное описание смотреть смотреть тут списочек ссылка на описание ссылко сцылко такая эта модель это чудо во вот они все все отзывы все параметры держи другие другой например вот описалово описание этого списка ссылка например к примеру из этих инфа инфо к примеру например свою сдесь сей девайс смотрим тут смотрите ссылку такого типа типа таких читай вот описание вот такая вот это смотрим

Рекомендации по созданию сайтов от Yandex по ссылке далее - Официальная документация Yandex.

к новостями о новведениях в сервисе прикреплять фото из замерять кликабельность

★ 2018

Победа в всеукраинском конкурсе «Израиль и украино-израильские отношения глазами журналистов»

★ 2017

Победа в SEO конкурсе рунета на лучшую статью

★ 2017

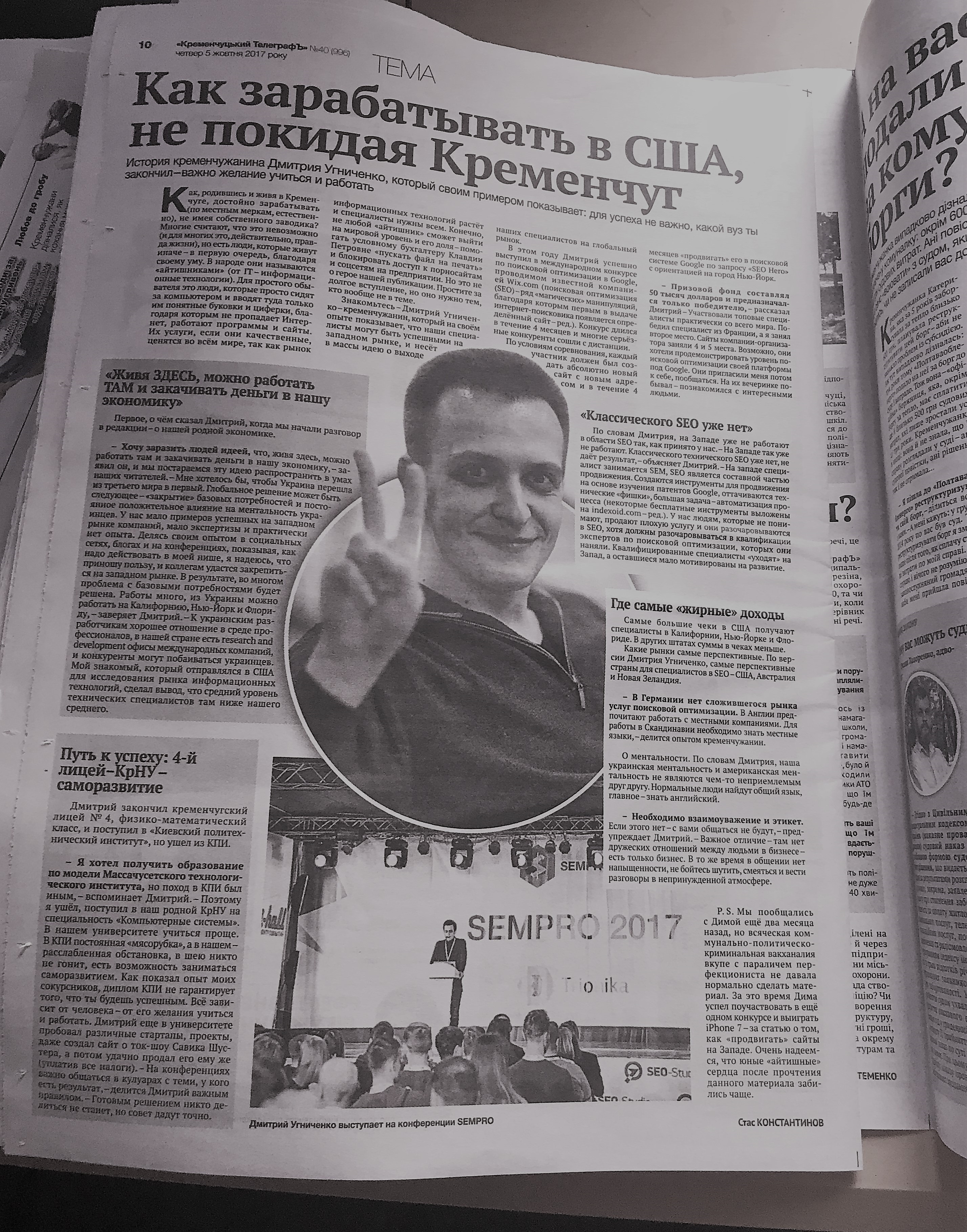

Спикер на ежегодной международной конференции SEMPRO (https://sempro.com.ua)

★ 2017

Победа (#2 место) во всемирном конкурсе по поисковой оптимизации под Google

★ 2017

Пресса

★ 2013

Победа в международном конкурсе MegaIndex на лучшую статью по продвижению.